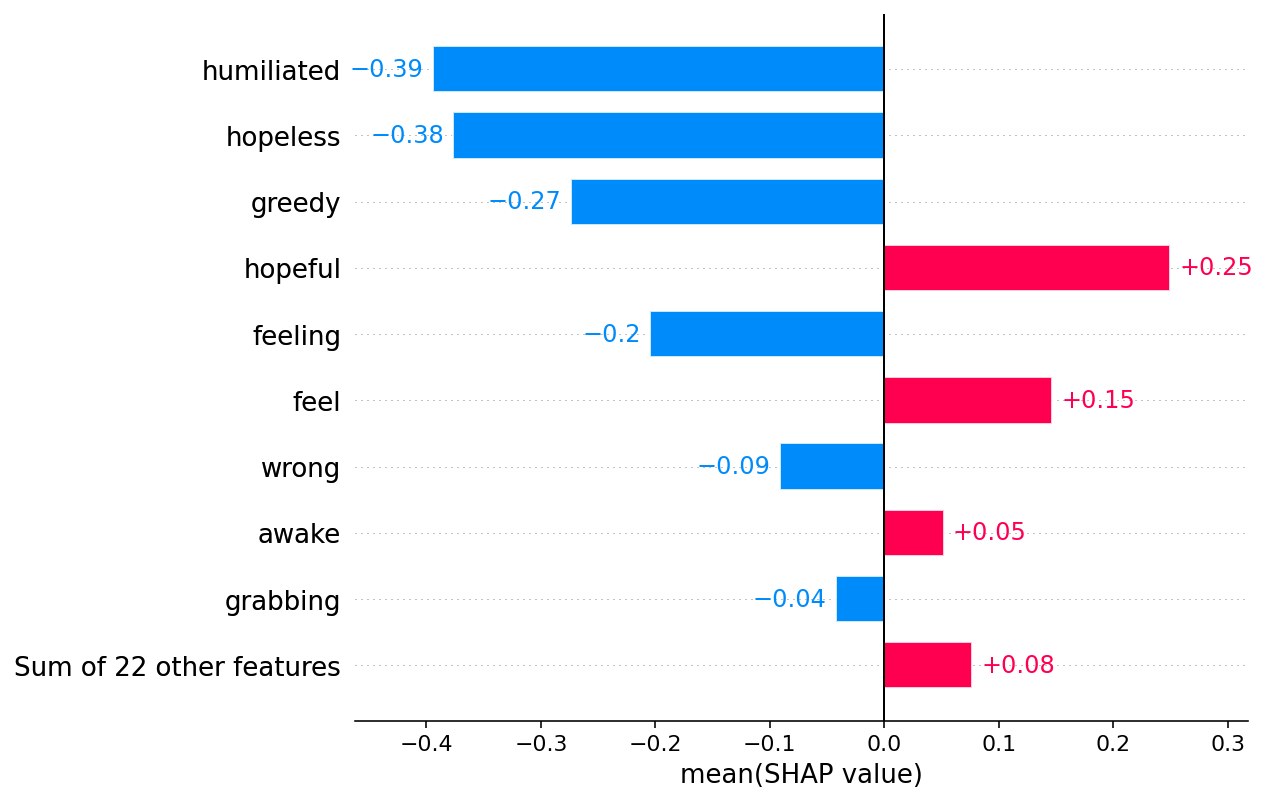

Come dimostrare che un modello di Intelligenza Artificiale sta funzionando come vorremmo? Come controllare quale parametro sta influenzando nel bene e nel male il risultato? La eXplainable AI si occupa proprio di questo. Andare oltre il luogo comune che sia tutto una blackbox.

Al Codemotion Workfest 2023, un mia sessione sul come occorre partire perché un modello sia “spiegabile”. Altri piccoli passi insieme a quelli per assicurarsi che un modello sia esportabile in ONNX, o ancora che ci si ponga le domande etiche a partire dall’analisi.

Inoltre non dimentichiamo che la eXplainable AI è un tassello base per la Responsible AI, e in generale per poter discutere sui temi della Etica della AI.